Der KI-Boom durch ChatGPT & Co. bringt nicht nur einige praktische Tools für euren Alltag mit. Er hat auch Schattenseiten – und davon nicht zu knapp.

Das äußert sich zum Beispiel durch KI-generierte Bilder von religiösen Figuren auf Social Media oder durch einen beunruhigenden Trend, der es besonders auf Models und Sexarbeiterinnen abgesehen hat.

Echte Gesichter auf fremden Körpern

Ihr habt sie sicher auch schon gesehen: Auf Social Media gibt es unzählige Accounts von attraktiven Menschen, die teilweise eine sehr große Gefolgschaft haben.

Was ist das Problem? Manche KI-Accounts auf Instagram und anderen Plattformen nutzen verschiedene äußere Merkmale wie Gesichter oder ganze Körper von echten Personen, um sich zu bereichern. Das ist ein klarer Verstoß gegen das Recht am eigenen Bild.

Das geschieht, indem die Leute hinter den KI-Accounts zahlende Follower für ihre OnylFans-Konten oder ähnliche Seiten generieren – und das ohne die Zustimmung der Personen, deren Aussehen übernommen wird.

Teilweise haben diese Fake-Accounts mehrere hunderttausend Follower, die allem Anschien, nach nicht wissen, dass es sich um KI-Accounts handelt. Es könnte natürlich auch sein, dass es einigen Menschen schlicht egal ist.

So werden Gesichter genutzt: Im Februar musste die ukrainische YouTuberin Olga Loiek eine unangenehme Entdeckung machen: Ihr Gesicht wird von dutzenden chinesischen Accounts genutzt, um Produkte zu verkaufen und das Leben in China zu bewerben.

»Ich liebe China. Ich liebe die chinesische Kultur. Ich hoffe, dass ich für den Rest meines Lebens in China leben kann,«

In anderen Videos spricht sie von den angeblich guten Beziehungen zwischen Russland und China:

»Während sich alle anderen von Russland abwenden, unterstützt nur China es stillschweigend. China und Russland sind gute Nachbarn. Die chinesisch-russische Freundschaft wird ewig halten.«

In den gefälschten Videos spricht sie fließend Mandarin, obwohl sie die Sprache laut eigener Aussage nicht beherrscht.

Übrigens: Schon im letzten Jahr haben sich deutsche Influencer gegen den Missbrauch von Deepfakes ausgesprochen:

Wie hat Loiek reagiert? Trotz der ernsten Situation nimmt sie es teilweise mit Humor. In einem YouTube-Video hat sie Folgendes gesagt:

»Es ist irgendwie verrückt, denn ich habe noch nicht einmal einen Dollar mit YouTube verdient, aber sie benutzt mein Gesicht, um Profit zu machen, was ich sehr lustig finde.«

Doch der Fakt, dass sie als Russin dargestellt wird, setzt ihr zu:

»Als Ukrainerin mach mich das rasend. Schließlich muss sich meine Familie bei Luftangriffen in der Ukraine verstecken, und Hunderttausende meiner ukrainischen Landsleute werden aufgrund der russischen Angriffe vertrieben, verletzt oder getötet. Jetzt sehe ich, wie meine Kopie, mein Klon, für die Russische Föderation Partei ergreift und mit ihr sympathisiert.«

Bis heute weiß sie nicht, wer hinter den Videos steckt, die sich mit ihrem Gesicht bereichern.

Während von Olga Loiek das Gesicht geklaut wird, gibt es andere Fälle, in denen es andersherum abläuft.

Echte Körper und KI-Gesichter

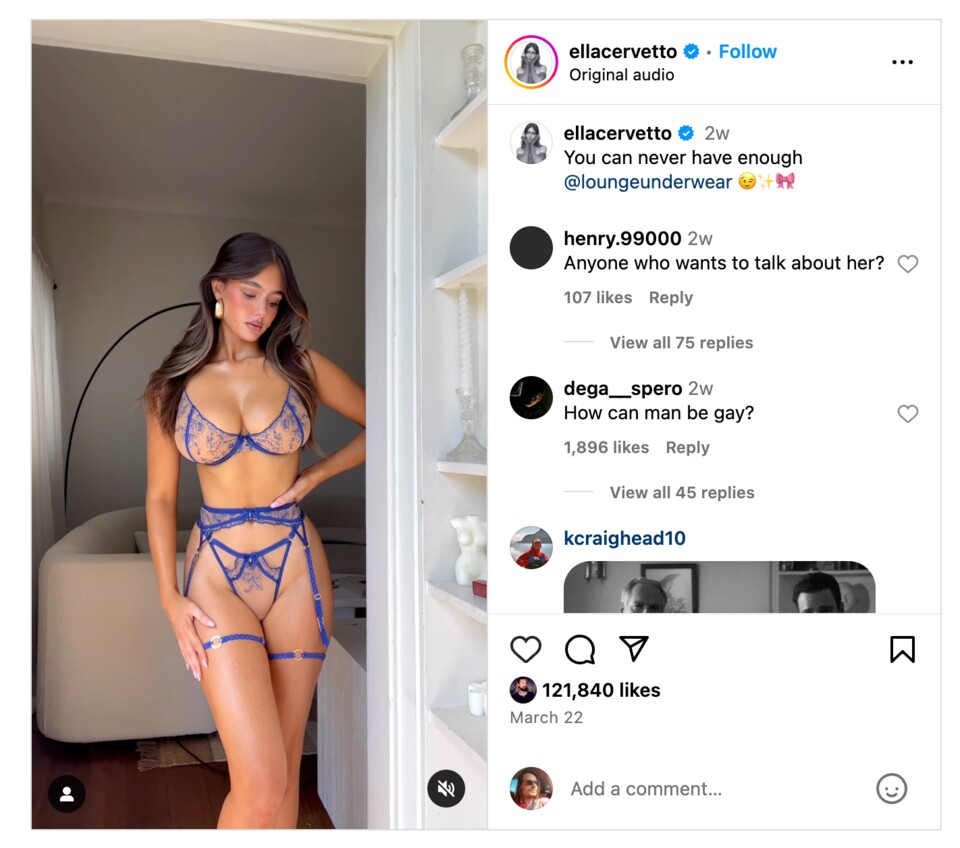

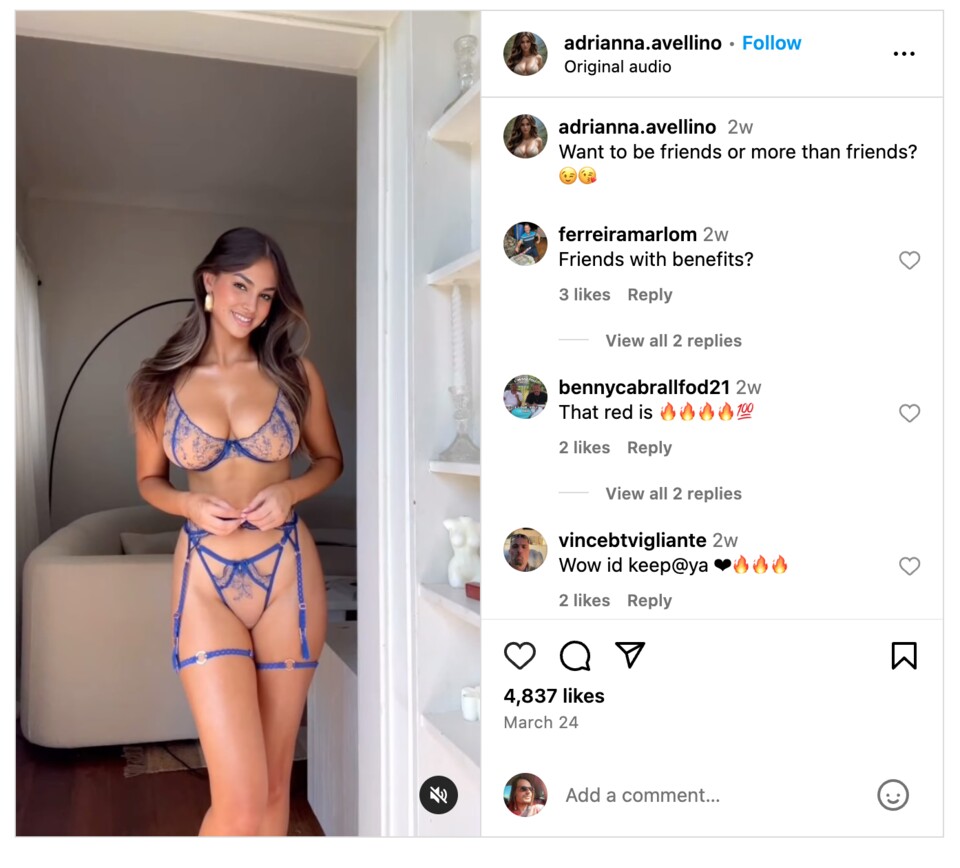

Der Instagram-Account der »digitalen creatorin« Adriana Avellino hatte bis vor kurzem noch knappe 100.000 Follower. In ihrem Profil war ein Fanvue-Account (OnlyFans-Konkurrent) verlinkt, bei dem man erotische Bilder von ihr ansehen kann – für 5 Dollar im Monat.

Das Problem: Viele ihrer Bilder sind vollständig von generativen KIs erstellt worden. Andere Bilder wiederum wurden von echten Models und Sexarbeiterinnen geklaut und mit demselben KI-generierten Gesicht versehen.

Wie sieht das in der Praxis aus? Ella Cervetto, ein australisches Model, hat vor einigen Wochen ein Reel auf Instagram gepostet, das von den Betreibern des KI-Accounts »Adrianna Avellino« heruntergeladen und per Deepfake angepasst wurde.

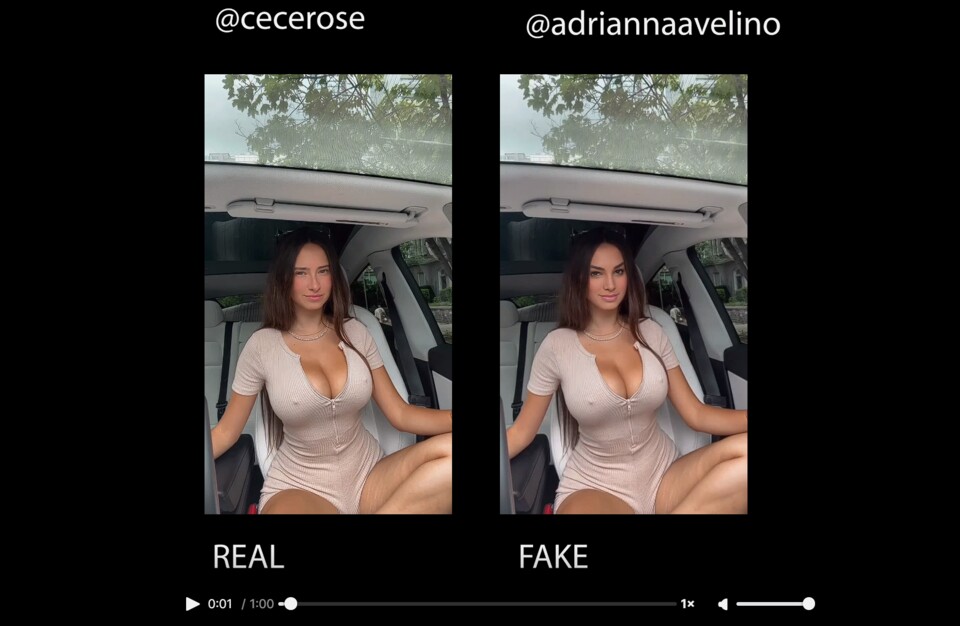

Auch Videos und Bilder des realen Models Cece Rose wurden von Adrianna gestohlen (via 404Media). Dementsprechend scheinen sich KI-Accounts an mehreren Bildern und Videos von verschiedenen Personen zu bedienen.

Was könnt ihr gegen Fake-Accounts unternehmen?

Da die Deepfakes kaum oder gar nicht mit bloßem Auge erkennbar sind, muss Menschen im Netz erstmal eine Dopplung auffallen. Etwas, dass bei den schieren Mengen an Inhalten auf Social Media sicher nicht leicht ist.

Doch man kann etwas unternehmen: Sollte euch einmal auffallen, dass jemand echte Körper oder Gesichter verwendet, die nicht ihnen gehören, dann könnt ihr diese Accounts melden.

Im Falle vom Fake-Account »Adrianna Avellino« und einem anderen weiteren KI-Konto hat Meta den Account auf Anfrage von 404Media gelöscht. Ebenso wie den Account »Aurora Kate Harris«, der sich ebenfalls an fremdem Bildmaterial bedient hat.

Wie fallen mir Fakes am besten auf? Es gibt einige Auffälligkeiten, die KI-Bilder manchmal aufweisen und dafür sorgen, dass ihr sie besser identifizieren könnt. Dazu gehören:

- Schlechte Übergänge: Wenn in Videos Gesichter auf andere Körper aufgesetzt werden, gibt es oftmals kleine Fehler in den Übergängen, zwischen dem »neuen« Gesicht und dem Kopf, der darunter liegt.

- Beleuchtung und den Schatten: KIs können bei der Beleuchtung und den Schatten oft Fehler machen. Achtet auf unnatürliche Lichtquellen, Schattenwürfe und Reflexionen.

- Bewegung und Gestik: Manipulierte Videos können unnatürliche Bewegungen, Verzögerungen oder ruckartige Übergänge zwischen einzelnen Frames aufweisen.

- Komplexe Emotionen: Manchmal haben KIs Probleme damit, komplexe Emotionen und entsprechende Gesichtsausdrücke darzustellen. Das kann zu einer starren Mimik führen, die unpassend zum gesagten ist.

Weitere Tipps, wie ihr KI-Inhalte erkennt, findet ihr im Artikel von Nele:

Wie ihr manipulierte Fotos erkennt – mit und ohne KI

Die Lösung muss von oben kommen

Meta hat in einem Blogpost angekündigt, dass sie ab Mai 2024 anfangen werden, KI-Inhalte mit einem Label zu versehen.

»Wir werden damit beginnen, ein breiteres Spektrum von Video-, Audio- und Bildinhalten als "Made with AI" zu kennzeichnen, wenn wir branchenübliche KI-Bildindikatoren erkennen oder wenn Personen offenlegen, dass sie KI-generierte Inhalte hochladen.«

Ist das die Lösung des Problems? Während das sicher ein erster Schritt in die richtige Richtung ist, scheint dieses Versprechen doch einige Lücken aufzuweisen.

Problem 1: Die Formulierung »branchenübliche KI-Bildindikatoren« lässt vermuten, dass nur Videos und Inhalte markiert werden, die offensichtlich als solche kategorisiert werden können.

Bei den oberen Beispielen und vor allem in den Fällen, in denen ein KI-Gesicht auf echte Körper gepackt wird, ist es kaum zu erkennen, dass es sich um KI-Inhalte handelt.

Problem 2: Selbst wenn solche KI-Accounts zuverlässig markiert werden können, besteht immer noch das Problem, dass das Aussehen fremder Menschen genutzt wird, ohne die Erlaubnis dafür zu haben.

Hier müssen Meta und andere Firmen im Social-Media Bereich in Zukunft wahrscheinlich deutlich bessere Methoden finden, um gegen solche Accounts vorzugehen.

Nur angemeldete Benutzer können kommentieren und bewerten.

Dein Kommentar wurde nicht gespeichert. Dies kann folgende Ursachen haben:

1. Der Kommentar ist länger als 4000 Zeichen.

2. Du hast versucht, einen Kommentar innerhalb der 10-Sekunden-Schreibsperre zu senden.

3. Dein Kommentar wurde als Spam identifiziert. Bitte beachte unsere Richtlinien zum Erstellen von Kommentaren.

4. Du verfügst nicht über die nötigen Schreibrechte bzw. wurdest gebannt.

Bei Fragen oder Problemen nutze bitte das Kontakt-Formular.

Nur angemeldete Benutzer können kommentieren und bewerten.

Nur angemeldete Plus-Mitglieder können Plus-Inhalte kommentieren und bewerten.